本周协助一家材料制造企业,解决其订单系统在全球访问速度慢、订单列表刷新时间长的问题。该企业的订单系统部署在武汉数据中心,主要面向中国大陆、美国、东南亚及欧洲等区域的员工使用。

业务与使用限制

由于系统使用人员来源复杂,企业明确提出以下前提条件:

- 不能要求用户安装专有客户端

- 不改变用户原有访问方式(浏览器直接访问)

- 系统架构与业务代码不做修改

订单系统以动态接口为主,包括订单查询、状态更新、报表生成等操作,所有请求都必须实时回源武汉,无法通过缓存方式优化。

一、问题分析

在网络优化前,全球用户均通过公网直接访问武汉源站。对于非大陆地区用户而言,请求需要跨越多段国际网络,路径不可控,延迟和丢包情况随运营商变化,页面加载和列表刷新经常出现卡顿。

二、企业安全与合规要求

在方案设计阶段,企业对安全与合规提出了明确要求:任何订单数据不得缓存或落地,所有请求必须实时回源,优化节点仅用于链路加速,不参与业务处理。证书和私钥由客户自行提供,网络侧仅对传输路径的稳定性和时延负责。本次优化只能从网络层入手,而不能采用内容分发或缓存方案。

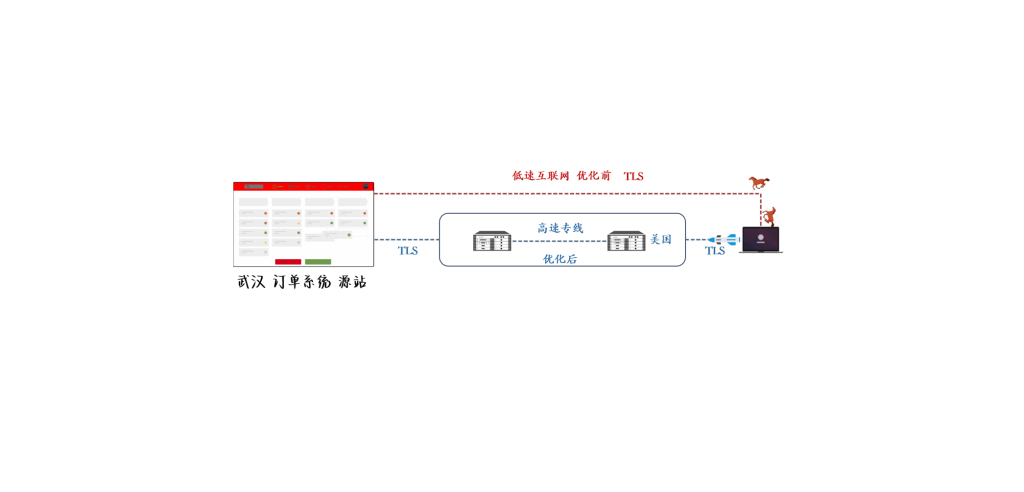

三、架构设计(优化后)

优化后采用全球就近接入 + 私有高速回源链路的方式:

- 全球用户自动接入距离最近的全球数据中心(亚洲 / 美洲 / 欧洲)

- 在接入节点终结 TLS

- 请求通过企业专用的优化骨干网回源武汉

- 中国大陆用户保持直连,不改变原有访问路径

四、访问效果对比测试

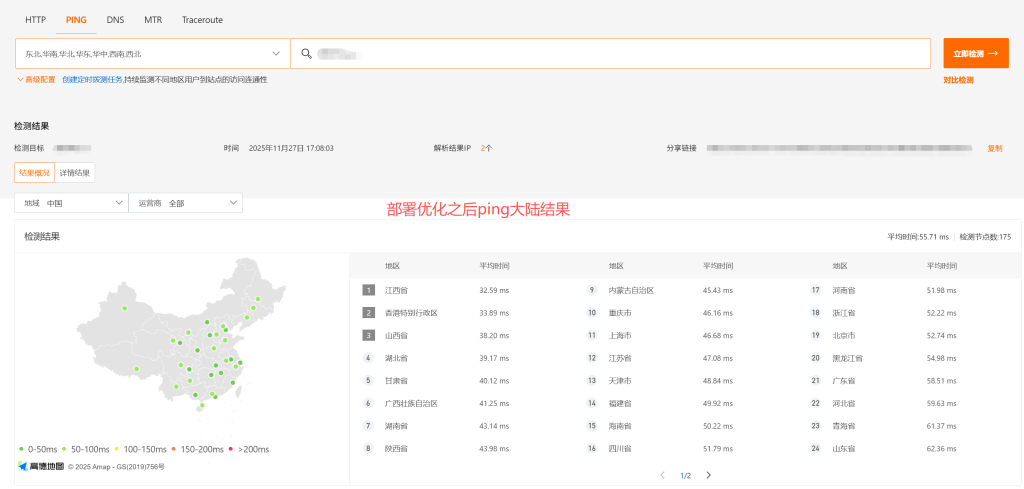

本次测试基于阿里云监测体系完成,使用 175 个中国大陆检测节点与 90 个非大陆检测节点,对同一域名在优化前后分别进行 Ping、HTTP 响应时间以及 DNS 解析等指标测试。

4.1 中国大陆 Ping 延时

- 优化前平均延时:58 ms

- 优化后平均延时:55 ms

结果说明:大陆用户保持直连武汉源站,路由未发生变化,延时基本一致。

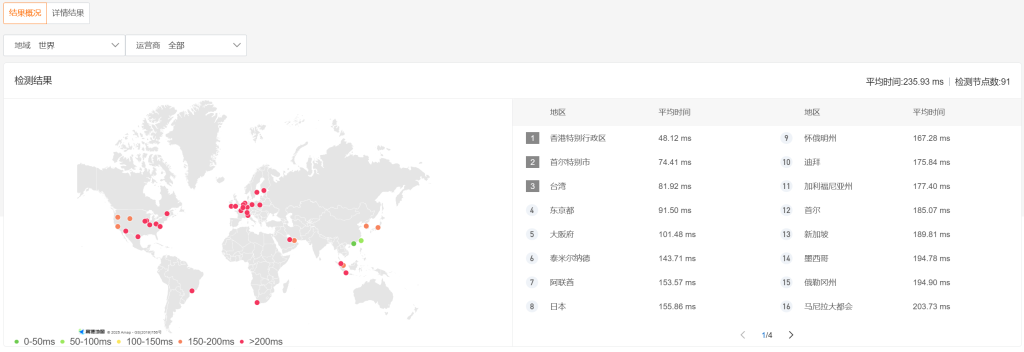

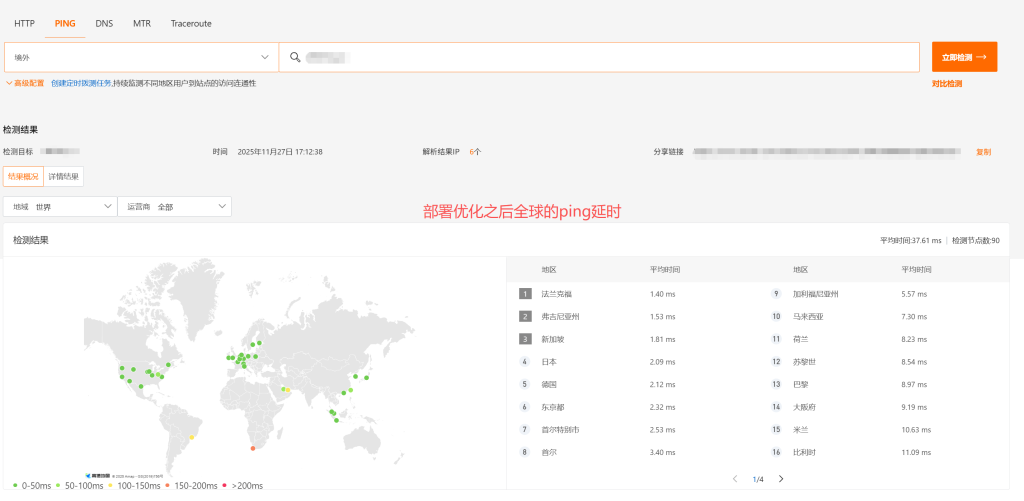

4.2 非大陆区域 Ping 延时

- 优化前平均延时:235 ms

- 优化后平均延时:37 ms

提升约 6.35 倍

原因在于 ICMP 请求被就近接入到全球节点,由最近节点响应,显著降低往返时延。

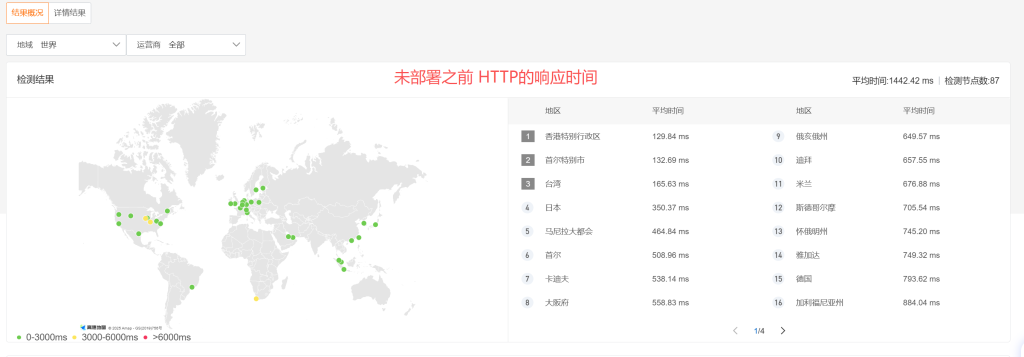

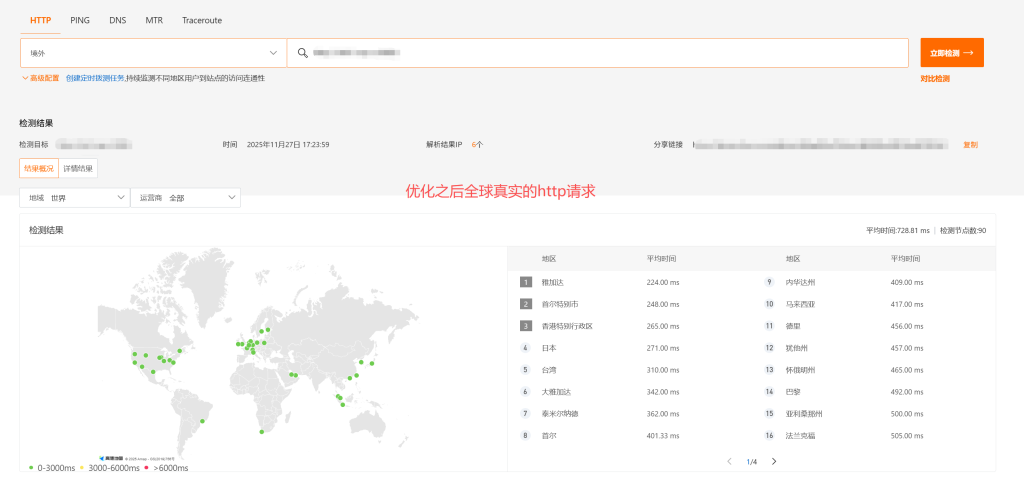

4.3 系统页面响应时间(HTTP)

该指标更贴近员工真实使用体验:

- 优化前平均响应时间:1442 ms

- 优化后平均响应时间:729 ms

响应时间提升约 1.98 倍

本次优化未缓存任何页面或接口数据,性能改善主要因为访问链路稳定性的提升,以及丢包和抖动的减少。

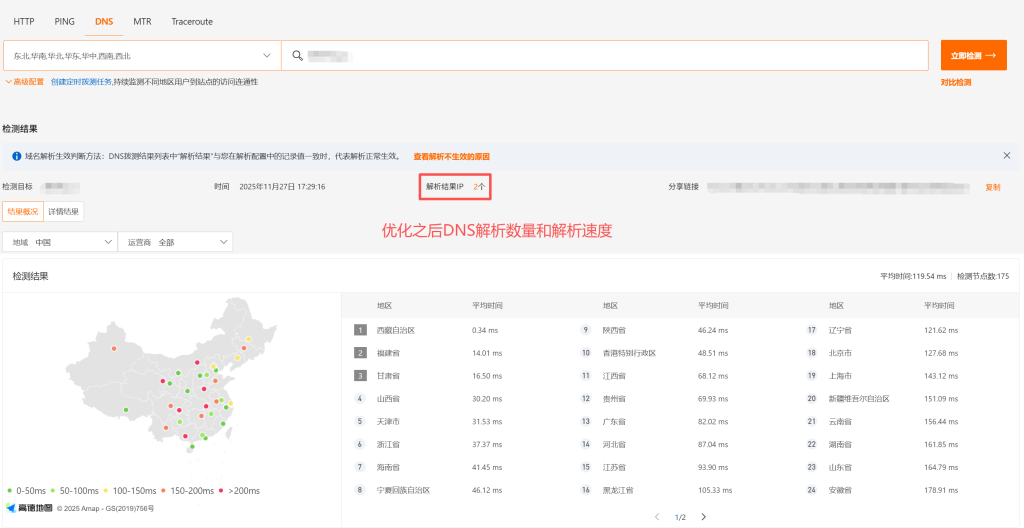

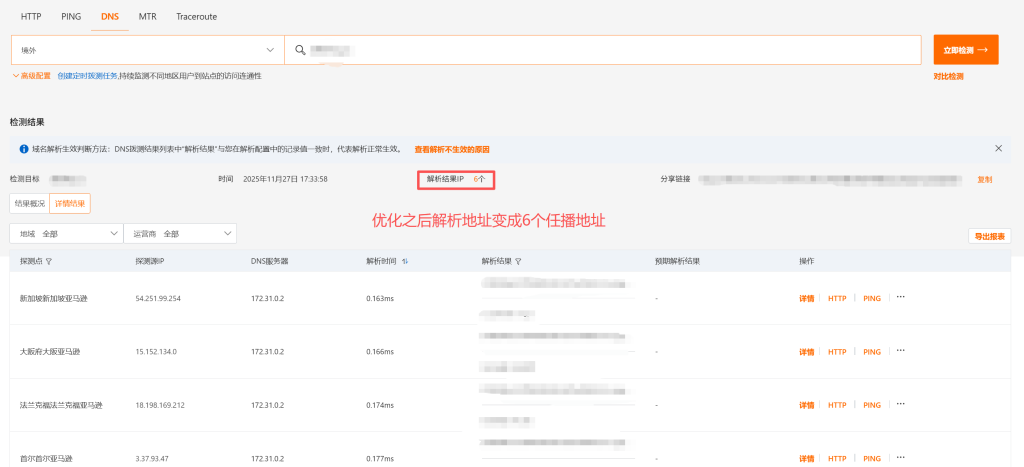

4.4 DNS 解析对比

- 优化前解析 IP 数量:2 个

- 优化后解析 IP 数量:6 个

不同地区可解析至更近的接入点,Anycast + GeoDNS 分流效果明显,为后续 HTTP 链路优化提供基础。

4.5 数据总结

| 测试指标 | 优化前 | 优化后 | 变化情况 | 说明 |

|---|---|---|---|---|

| 中国大陆 Ping 延时 | 58 ms | 55 ms | 基本不变 | 大陆用户保持直连武汉源站,访问路径未调整 |

| 非大陆区域 Ping 延时 | 235 ms | 37 ms | ↓ 约 6.35 倍 | ICMP 请求就近接入全球节点,由最近节点响应 |

| 系统页面响应时间(HTTP) | 1442 ms | 729 ms | ↓ 约 1.98 倍 | 未做任何缓存,主要来自跨洲链路稳定性提升 |

| DNS 解析 IP 数量 | 2 个 | 6 个 | 接入点增多 | Anycast + GeoDNS 分流生效,就近接入 |

五、整体效果总结

本次方案主要用于解决企业核心系统集中部署在国内,但需要面向全球员工或合作方访问时出现的响应慢、加载不稳定问题。在不调整系统部署位置、不修改业务代码、不改变用户使用方式的前提下,仅通过网络路径优化,显著改善了跨洲访问体验。

特点在于只对传输链路进行优化,不介入业务逻辑,不进行任何形式的缓存或数据落地,对使用人员完全无感知,适用于对稳定性和合规要求较高、且系统架构难以调整的企业场景。

基于真实环境整理,如需进一步沟通相关需求,可通过页面右侧方式与我联系。